Category Archives: DevOps

Ресурс Role определяет, какие действия можно предпринимать и на каких ресурсах (или какие типы HTTP-запросов можно выполнять и на каких ресурсах RESTful). В следующем ниже листинге определяется роль, которая позволяет пользователям получать и выводить список служб в пространстве имен boo.

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: namespace: boo name: service-reader rules: - apiGroups: [""] verbs: ["get", "list"] resources: ["services"]

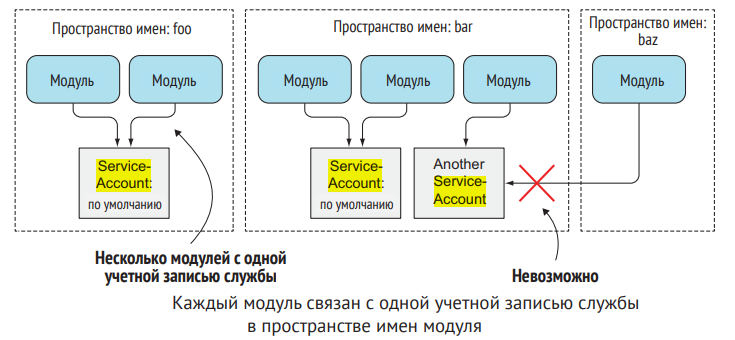

Учетные записи ServiceAccount – это ресурсы, такие же, как модули, секреты, словари конфигурации и т. д., которые ограничиваются отдельными простран[1]ствами имен. Устанавливаемая по умолчанию учетная запись ServiceAccount создается автоматически для каждого пространства имен (именно их и ис[1]пользовали ваши модули все время). Список учетных записей ServiceAccount можно вывести точно так же, как вы делаете это с другими ресурсами:

$ kubectl get sa

Текущее пространство имен содержит учетную запись по умолчанию ServiceAccount. При необходимости могут быть добавлены дополнительные учетные записи служб. Каждый модуль связан ровно с одной учетной записью службы, но несколько модулей могут использовать одну и ту же учетную запись. Как видно на рисунке, модуль может использовать учетную запись ServiceAccount только из того же пространства имен.

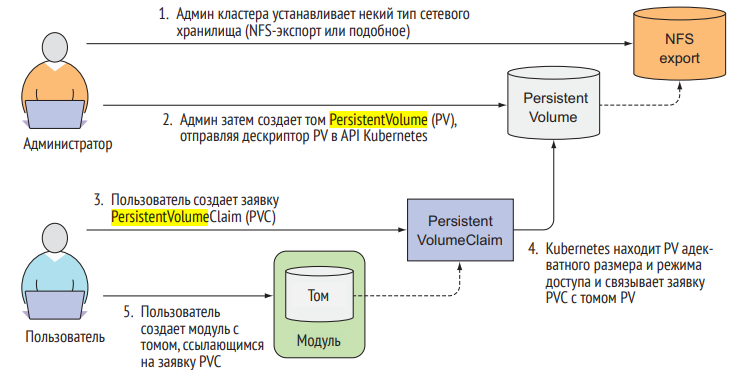

Для того чтобы позволить приложениям запрашивать хранилище в кластере Kubernetes без необходимости иметь дело со спецификой инфраструктуры, были введены два новых ресурса. Это постоянный том (PersistentVolume) и заявка на постоянный том (PersistentVolumeClaim). Эти имена могут вводить в заблуждение, поскольку, как вы видели в предыдущих томах, даже обычные тома Kubernetes могут использоваться для постоянного хранения данных. Использовать постоянный том PersistentVolume внутри модуля немного сложнее, чем использовать обычный том модуля, на рисунке показано каким образом связаны между собой модули, заявки на постоянный том PersistentVolumeClaim, постоянные тома PersistentVolume и фактическое базовое хранилище.

Часто при запуске программы Linux apt или apt-get выходит ошибка в терминале:

E: Could not get lock /var/lib/dpkg/lock – open (11: Resource temporarily unavailable)

Формулировка ошибки и путь к lock-файлу могут отличаться в зависимости от конкретного случая, но если речь идет о невозможности заблокировать файл dpkg, все они будут устраняться схожими методами.

По сути, ошибка связана с тем, что файл менеджера пакетов dpkg уже заблокирован — то есть, уже выполняется какой-то процесс, который его использует, или выполнение процесса было завершено некорректно.

В первую очередь рекомендуем подождать несколько минут и попробовать запустить apt снова. Вполне возможно, что выполняемый процесс через пару минут автоматически завершится, и вы сможете продолжить работу.

Если же проблема сохраняется, ее можно решить следующими способами. (далее…)

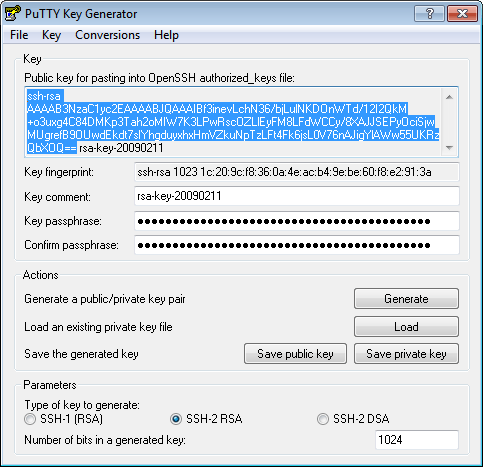

Как настроить аутентификацию по SSH ключам с помощью PuTTY и Linux-сервера

В этом руководстве объясняется, как можно заменить SSH-аутентификацию на основе пароля аутентификацией на основе ключа, которая более безопасна, поскольку входить в систему могут только пользователи, которым принадлежит ключ. В этом примере мы используем PuTTY в качестве нашего SSH-клиента в системе Windows.

Сгенерируйте пару закрытого и открытого ключей

Откройте PuTTYgen.exe, нажмите кнопку сгенерировать, наведите курсор мыши. Как только ключи будут сгенерированы, введите ключевую фразу-пароль (выберите «трудно угадываемую»). Сохраните открытый ключ. Сохраните закрытый ключ.

Генератор ключей PuTTY

Настройте свой Linux-сервер (создайте пользователя, сохраните открытый ключ)

Для этого руководства давайте предположим, что ваше обычное имя для входа usr (замените его на то, которое вы используете регулярно). (далее…)

0